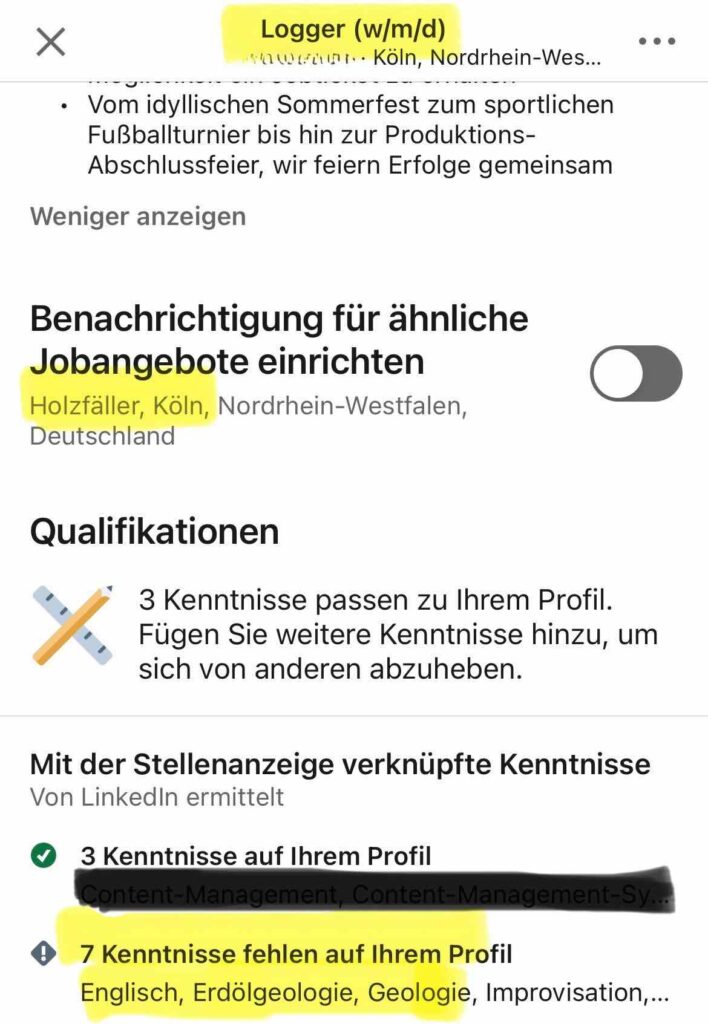

Zugegebenermaßen ein fast nachvollziehbarer LinkedIn KI-Fail, der mir beim Scrollen in der App ins Auge fiel und zeigt, warum Menschen am Ende doch noch das letzte Wörtchen oder den letzten Blick auf ein Produkt haben sollten. Die LinkedIn-KI übersetzte den Jobtitel „Logger“ – eine Position in der Medienproduktion, bei der Inhalte protokolliert und aufbereitet werden – kurzerhand als „Holzfäller“. Nicht ganz falsch, aber eben völlig aus dem Kontext gerissen und damit auch überhaupt nicht richtig.

Im deutschen Sprachgebrauch würde „Logger“ eher als Datenprotokollierer im Medien- oder IT-Bereich verstanden, und nicht in Verbindung mit Forstarbeit. Doch damit nicht genug: Die KI weist dadurch in Profilen auf fehlende Qualifikationen wie Erdölgeologie, Geologie und Mudlogging hin – Skills, die für die Medienproduktion wenig relevant sind, aber in der Forstwirtschaft eine Rolle spielen könnten.

Dieser LinkedIn KI-Fail zeigt, wie wichtig das Kontextverständnis ist und wo automatisierte Systeme an ihre Grenzen stoßen. Ein Grund mehr, warum der Mensch am Ende nicht alles der Künstlichen Intelligenz überlassen sollte. 😃

LinkedIn KI-Fail zum Lachen

Dieser Fehler ist ein klassisches Beispiel für einen „Contextual Error“. Ein Fehler, der entsteht, wenn eine KI den Kontext eines Wortes nicht richtig erfasst und eine unpassende Bedeutung auswählt. Da maschinelle Lernsysteme auf großen Datenmengen und Mustern basieren, neigen sie dazu, die am häufigsten vorkommende Bedeutung eines Begriffs zu verwenden, wenn der Kontext unklar ist. Im Fall von „Logger“ bevorzugte die KI die Bedeutung „Holzfäller“, da diese im Englischen häufiger vorkommt – ohne den spezifischen Kontext der Medien- oder Produktionsbranche zu berücksichtigen.

Solche „Contextual Errors“ sind eine bekannte Herausforderung in der KI-basierten Sprachverarbeitung. Sie zeigen, dass Maschinen zwar Muster erkennen, aber nur bedingt Sinn verstehen. Ein Beispiel dafür, dass KI mächtig, aber auch nicht unfehlbar ist!

Diese Art von Fehlern verdeutlicht die Grenzen der aktuellen KI-Technologien und erinnert uns daran, dass Sprache und Bedeutung in kulturellen und branchenspezifischen Zusammenhängen verankert sind, die eine KI oft nicht vollständig erfasst. Während maschinelle Lernmodelle Millionen von Datenpunkten analysieren und daraus Vorhersagen ableiten, fehlt ihnen das intuitive Verständnis, das Menschen besitzen.

Worte wie „Logger“ haben in verschiedenen Kontexten unterschiedliche Bedeutungen, die je nach Umgebung, Zielgruppe und Zweck variieren. Menschen können diese Nuancen durch Erfahrung und Wissen schnell erfassen und interpretieren, während KI-Modelle oft auf Mustern und Häufigkeiten basieren, ohne den spezifischen Kontext oder kulturellen Hintergrund zu verstehen. Gerade im Bereich der Sprachverarbeitung stößt die KI an ihre Grenzen, wenn es um idiomatische, kulturell geprägte oder branchenspezifische Begriffe geht. Hier zeigt sich, dass menschliche Intuition und das Wissen um den Kontext weiterhin unverzichtbar bleiben – hauptsächlich in Bereichen, in denen fehlerhafte Interpretationen erhebliche Missverständnisse oder sogar Fehlentscheidungen nach sich ziehen könnten.

Und mir zeigt dieser Post, dass ich im Hinblick auf ‚Englisch-Kenntnisse‘ auf LinkedIn dringend noch etwas nachtragen sollte … Mittlerweile bin ich sicher, dass es neben diesem LinkedIn KI-Fail deutlich mehr Schwierigkeiten auf Jobportalen gibt, also solche.

Vielleicht auch interessant:

- Weitere Definitionen und Begriffserklärungen rund um die Künstliche Intelligenz gibt es in unserem KI-Glossar.

1 Gedanke zu „LinkedIN KI-Fail: wenn aus dem Logger ein Holzfäller wird“